Qwen(通义千问)是阿里云 / 通义团队推出的一整套大模型家族,涵盖从轻量级到万亿参数的多类模型,支持文本、图像、音频、视频等多种模态处理。

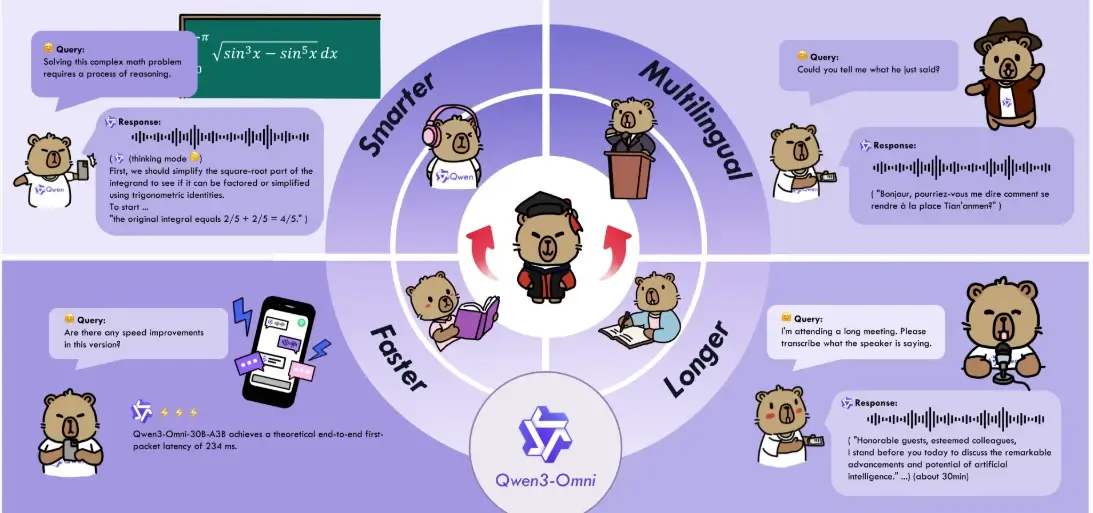

该系列坚持开源与闭源双轨并行的策略,近期重磅发布的多模态模型Qwen3-Omni更是成为全球首个原生端到端全模态AI模型,在多项基准测试中表现出色

主要模型

Qwen系列不同模型针对不同需求设计,功能覆盖全面:

| 模型名称 | 核心功能 | 模态支持 | 关键特性 |

|---|

| Qwen3-Omni | 全模态交互 | 文本、图像、音频、视频 | 实时流式响应,Thinker-Talker架构,支持119种文本语言和19种语音输入 |

| Qwen3-Max-Preview | 超大规模复杂任务 | 文本 | 万亿参数,在专业领域知识幻觉少,适合医疗、法律等精确度要求高的场景 |

| Qwen3-Next-80B-A3B | 高效推理与代码生成 | 文本 | 稀疏MoE架构,仅激活3B参数,支持长上下文(262K token) |

| Qwen3-235B-A22B | 高性能开源 | 文本 | 与DeepSeek-R1、Grok-3性能相当,成本降低65-75% |

| Qwen-VL | 视觉语言处理 | 文本、图像 | 图像描述、视觉问答 |

| Qwen-Agent | 工具调用与自动化 | 多模态 | 支持工具调用、任务自动化 |

使用教程(快速上手三步)

- 试用(最快):打开官网或 Qwen Chat(https://chat.qwen.ai/),直接在网页/APP 上和模型交互,体验对话、多模态处理等功能。网页端常提供免登录或低门槛体验。

- 开发者集成(API):在阿里云注册并进入 Model Studio / 大模型服务(百炼),选择你想的 Qwen 模型,获取 API key,然后用 OpenAI-兼容或厂商 SDK 调用模型(请求示例、token 与上下文参数在文档里有详细说明)。适合把 Qwen 嵌入产品。

- 本地 / 离线部署:到官方 GitHub / HuggingFace 下载开源权重(按许可使用),然后用常见的推理框架(如 FlashAttention、DeepSpeed、vLLM 等)和多卡/分布式推理方案部署。官方 repo 有示例和说明。